人工智能 | 项俊平:深度强化学习的交通信号优化控制浅析

5月30日—31日,第一届未来交通控制理论与系统大会在同济大学召开。项俊平发表了《基于深度强化学习的交通信号优化控制浅析——以DQN模型为例》主题演讲。

5月30日—31日,第一届未来交通控制理论与系统大会在同济大学召开。会上,连云港杰瑞电子有限公司智慧城市事业部总经理项俊平发表了《基于深度强化学习的交通信号优化控制浅析——以DQN模型为例》主题演讲。

以下为项俊平演讲全文:

关于未来的交通信号控制的发展方向,我首先想到的是人工智能技术的应用。基于人工智能的交通信号控制这个主题的范围很大,所以今天的汇报我把落脚点放在“基于深度强化学习的交通信号优化控制”方面,谈谈DQN,即基于神经网络的深度强化学习模型,请大家批评指正。

1.人机大战:(柯洁)“我与它的差距会越来越大”

我们知道,三天前,AlphaGo以3:0战胜了柯洁。在赛后的新闻发布会上,柯洁以冷静、可怕形容他的对手,表示他与AlphaGo的差异将会越来越大。

柯洁认为差距越来越大是可以理解的。因为人通过学习达到快速进步需要较长的时间和过程,而机器只要有适当的数据,就能够通过自学习达到快速的进步。

AlphaGo给我们展示的是数据驱动模型的强大能力。众所周知,AlphaGo是由DeepMind团队开发的,深度强化学习是DeepMind(后被谷歌收购)近几近来重点研究且发扬光大的机器学习算法框架。DeepMind团队的两篇Nature上的奠基性论文(DQN和AlphaGo)使得DRL这一深度学习和强化学习的交叉方向变得炙手可热。

让我们开始关注DeepMind的工作,是从他们利用深度强化学习方法训练计算机玩打砖块游戏开始的。在做这件事的过程中,放置一台摄像机对着计算机游戏屏幕,然后将数据传到GPU和CPU中进行计算,计算机做出游戏步骤的决策,系统给每一步决策进行打分评价。这里有一个重要因素,就是“打分”,正因为有适当的评分系统,计算机才知道“他”学习的效果,并逐步改进。通过一整套的自动训练流程,让“他”学会了怎么去打游戏,而且战胜了众多的人类高手。

2.人是如何依靠经验指挥交通呢?

人指挥交通的经验是通过不断实践积累的。人利用五官观测感知环境,根据观测的情况,采取行动指挥交通,然后根据行动反馈的结果,形成经验。这个“观测-行动-反馈”的过程,使人通过学习积累了经验,通过不断反馈形成的经验能使行动做的更好。

强化学习本质就是解决“决策”问题,即通过试错学会自动决策。强化学习最早来源于巴普罗夫的条件反射,上世纪90年代左右,强化积极参与人工智能,机器学习领域才得到广泛应用。

强化学习技术是从控制理论、统计学、心理学等相关学科发展而来,最早可以追溯到巴甫洛夫的条件反射实验。但直到上世纪八十年代末、九十年代初强化学习技术才在人工智能、机器学习和自动控制等领域中得到广泛研究和应用,并被认为是设计智能系统的核心技术之一。特别是随着强化学习的数学基础研究取得突破性进展后,对强化学习的研究和应用日益开展起来,成为目前机器学习领域的研究热点之一。

强化学习是一类算法,是指从环境状态到行为映射的学习,以使系统行为从环境中获得的累积奖励值最大;在强化学习中,我们并没有直接告诉主体要做什么或者要采取哪个动作,而是主体通过看哪个动作得到了最多的奖励来自己发现规律。试错搜索和延期强化是强化学习方法最重要的特性。

计算机也需要一位好老师,这个老师比较吝啬,他不会告诉你如何行动,如何做决定。他为你做的事情只是为你的行为打分。那么我们该怎么利用打分或者说现有的资源学会做决定呢?很简单,我们只要记住那些高分或低分对应的行为,下一次同样的行为拿到高分并避免低分的行为。这也是强化学习的核心思想。强化学习中打分很重要,因此强化学习是分数导向性。

3.打造交通信号控制的强化学习系统

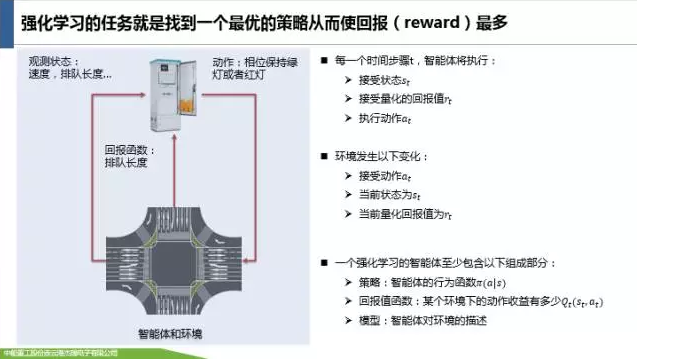

如果把由信号机、检测器等组成的交通信号控制系统当成一个“智能体”,将我们目睹的人车路当成“环境”,通过如下方式就可以构造强化学习系统:传感器从环境里获取观测状态(例如:流量、速度、排队长度等),传递给信号机,信号控制系统根据这些状态来选择一个得分最高状态的动作来执行(例如:当前相位保持绿灯或者切换成红灯),并对执行效果进行回馈(例如:采用排队长度作为回报函数),系统根据回报结果,调整打分系统的参数。这样就形成一个循环的过程,就能达到不断学习改进。

一个基于强化学习系统的交通信号控制系统应该怎么编码呢?

下面我介绍一种编码模式。将路口进行网格化,形成一个按道路划分的具有一定长度(例如:介于2米~5米之间)互不重叠的格点区域。基于格点区域,我们给每个交叉口赋予状态(例如:交叉口车辆和信号灯状态,车位置、速度等,车流量,相位红灯/绿灯持续时间等),定义动作(例如:某个阶段,东直+西直绿灯,其它红灯),组成了状态空间和动作空间。状态和动作之间需要一个值函数,就是如何打分,即:在某个状态中执行完某个动作后,长效作用的最好的得分,即最大折扣未来奖励,打分函数我们可以用排列长度、延误或者其他一些评价参数。

Q 学习的思想完全根据值迭代的。但要明确一点是值迭代每次都对所有的Q值更新一遍,也就是所有的状态和动作。但事实上在实际情况下我们没办法遍历所有的状态和所有的动作,我们只能得到有限的系列样本。因此,只能使用有限的样本进行操作。那么,怎么处理?Q 学习并没有直接将这个Q值(是估计值)直接赋予新的Q,而是采用渐进的方式,朝目标迈近一小步,这就能够减少估计误差造成的影响。类似随机梯度下降,最后可以收敛到最优的Q值。算法中的参数alpha是指学习率,其控制前一个Q值和新提出的Q值之间被考虑到的差异程度。尤其是,当alpha=1时,两个Q[s,a]互相抵消,结果刚好和贝尔曼方程一样。

我们用来更新Q[s,a]的只是一个近似,而且在早期阶段的学习中它完全可能是错误的。但是随着每一次迭代,该近似会越来越准确;而且我们还发现如果我们执行这种更新足够长时间,那么Q函数就将收敛并能代表真实的Q值。

4.基于深度Q学习(DQN)的优化算法

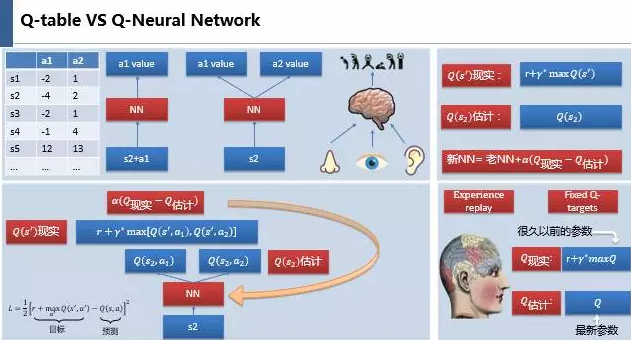

上面描述的Q是一个矩阵,如果当系统状态空间非常大的时候,矩阵的规模会非常大,这样就陷入了所谓的“维度灾难”,计算机存储和搜索超大表格效率太低、甚至不能实现。机器学习中有一种形式对处理这种事情很在行,他就是神经网络。我们可以将状态+动作作为神经网络的输入,通过神经网络的分析后,得到状态和动作对应的分数;还有一种形式,我们只输入状态,通过神经网络输出所有的动作对应的Q值,然后按照Q-learning的原则选择最大值的动作作为下一个要做的动作。神经网络接受外部的信息相当于鼻子耳朵接受信息,通过大脑加工输出每一种动作的值,然后通过强化学习选择最合适的动作。若采用深度神经网络,那么整个算法就是基于深度Q学习的算法了,简写为DQN,即:Q学习+深度(卷积)神经网络。

神经网络是需要训练才能得到准确的值的。那么神经网络是如何被训练的呢?首先要计算所有可能动作对应的正确的Q值,我们记为Q(现实),还需要一个Q(估计)来用于神经网络的更新,所有新的神经网络的参数就是老的神经网络参数加上alpha乘以(Q(现实)-Q(估计))。

我们通过神经网络估计出当输入为S时,所有可能动作的Q值(这就是Q估计),然后我们通过Q估计中值最大的值对应的动作来换取环境中的奖励R和下一步的环境状态S’。此时我们就可以计算出Q(S’)的现实取值,然后通过误差更新神经网络,使神经网络具备储存这种误差经验的能力。

DQN两大因素使其能够具备强大学习能力的原因有两个:1.经验回放:DQN更新时随机抽取最新的、过去的、甚至关联系统的经验,打破了经验之间的相关性,也使得网络更新更有效率;2.固定的Q目标:这也是一种打破相关性的措施。在DQN中使用两个结构相同、参数不同的网络,预测Q估计的神经网络利用最新的参数,预测Q现实的参数使用的是很久以前的参数。

我们以车辆位置和车辆速度构建的归一化矩阵作为卷积神经网络的输入,通过卷积、池化、非线性映射等技术,将输入矩阵进行先升维再降微的操作,迭代更新状态-动作Q值矩阵,并选择Q值最高的信号控制动作去执行,以相对排队长度为打分指标,就可以构造一个基于DQN的交通信号控制优化模型。通过仿真测试,相比于定时控制,基于相对排队长度的DQN学习算法可以有效的降低交叉口平均等待时间。具体模型细节在此不再赘述。

5.小结

自问世以来,深度Q 学习已经取得了很多改进,比如:双Q学习、优先经验回放、竞争网络架构和连续动作空间的扩展等,深度Q学习已被谷歌申请了专利。

人们常常说,人工智能是一种我们仍未清楚明白的东西,一旦我们理解了它们的工作方式,它就看起来不再智能了,但是深度Q网络仍然让我们惊叹。

随着车路协同、高精度位置定位和车联网技术的发展,以深度强化学习为代表的人工智能学习方法,必将在交通信号控制中发挥重要的实战作用。杰瑞集团已经在一些地方部署了北斗高精度定位系统,可以做到整个城市车辆厘米级别的定位,在这种情况下,车辆在哪个车道、在车道的什么位置都可以定位到,道路的网格化、矩阵化也就成为可能。

强化学习模型中,最要一个打分函数,如果分打的不好,优化会走向反的坏方向,要依靠交通工程专家去建立打分恰当的模型,并且解决自动打分问题,这是强化学习模型在交通信号优化控制现实应用中需要重点考虑的问题。

谢谢大家。

未经许可,任何人不得复制、转载、或以其他方式使用本网站的内容。如发现本站文章存在版权问题,烦请提供版权疑问、身份证明、版权证明等材料,与我们联系,我们将及时沟通与处理。