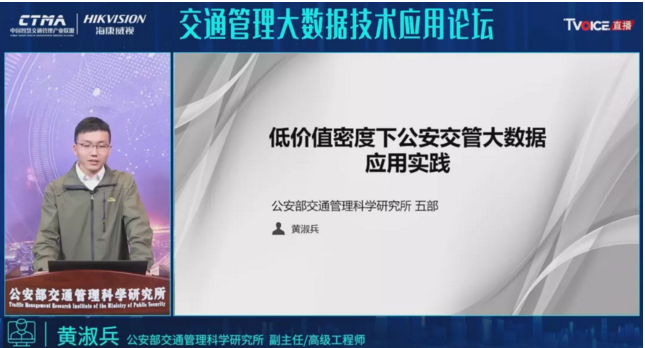

公安部交科所黄淑兵:交管大数据低价值密度问题的思考

大数据处理技术已经相当成熟,交管大数据应用还远远没有跟上。

近年来,各大城市的监控设备随着经济发展得到大规模建设,也推动了警务信息化进程,各类视频监控终端和信息采集系统遍布整座城市,这些设备每天都为交通管理者采集了大量的数据,未来交通的发展,数据的应用价值将会越来越大,数据的交互与碰撞能够为交通可持续发展带来新的内涵。

大数据是交通信息化管理的使用方法之一,新时代的道路交通管理工作面临新挑战、高要求,利用大数据的信息技术解决各类交通问题刻不容缓。在城市交通治理实践中,大数据的作用愈发凸显,如何挖掘应用数据?如何利用大数据进行城市交通治理?业界都非常关注。

10月21日,交通管理大数据技术应用论坛在赛文直播平台进行了直播。期间,公安部交通管理科学研究所五部副主任黄淑兵进行了主题为“低价值密度下公安交管大数据应用实践”的演讲,以下为演讲实录。

大家看到题目可能会有一个疑问,为什么说公安交管大数据的价值密度比较低?可能有人会说,我们公安交管的机动车信息、驾驶人信息,它的价值还是比较高的,甚至有些灰色产业链,还会售卖公安交管的数据,而且价格可能还不便宜。

但是,我们今天说的交管大数据的价值,不是说它的实际售卖价值,而是说它在大数据分析里面可以发挥的作用。机动车、驾驶人数据严格意义上来说也不能算是大数据。我们这里所说的大数据主要是指汇聚接入公安交通集成指挥平台的道路交通监控设备抓拍的车辆通行轨迹数据,这个数据量非常庞大,目前已超万亿。

首先我们回顾一下大数据的5V特征。

Volume(容量) 数据量大,包括采集、存储和计算的量都非常大

Variety(种类) 种类和来源多样化,包括结构化、半结构化和非结构化数据

Value(价值) 数据价值密度相对较低,或者说是浪里淘沙却又弥足珍贵

Velocity(速度) 数据增长速度快,处理速度也快,时效性要求高

Veracity(真实) 数据的准确性和可信赖度,即数据的质量

价值密度低的具体表现

那么,交管大数据的价值密度低,它到底低在哪里呢?

具体表现在数据质量不高、覆盖面不全两个方面。

第一个方面,从数据质量的角度来说,交管大数据(主要是公安交通集成平台汇聚的道路交通卡口采集的车辆通行轨迹数据)数据质量不高。

根据《道路车辆智能检测记录系统通用技术条件(GAT/497-2016)》:日间车辆号牌号码识别准确率应不小于95%;夜间车辆号牌号码识别准确率应不小于90%。

按照最理想的环境进行检测,成像的角度、图片的清晰度、包括场景都比较单一,所以在一般标准场景下基本上能达到上述的两个指标。

但实际上卡口都是安装在路面上,在实际路面中我们抽选了一些卡口的图片进行人工的核实和确认,发现很多问题。

比如,图片清晰首汉字识别错误;图片模糊把同一个首汉字识别成不通的汉字,如湘识别成浙、鲁识别成冀等等;把非机动的号码识别成机动车的号码;由于角度问题,把机动车上某一处的数字或者进气栅识别成号牌号码;数字或字母识别错误,如1识别成J,E识别成F,D、Q识别成0等……

基于目前这种情况,卡口的识别准确率比较低,也就意味着采集到的数据跟实际需求并不相符。

前一段时间,我们在条件比较好且场景单一的高速公路上拍摄单个车道的卡口图片,然后对已识别号牌的图片进行抽样分析,结果显示,大车识别准确率约为80%,小车识别准确率约为87%。

这两个数字表面看起来距离标准的要求很接近,但实际上我们挑选的样本是对已经识别出号牌的图片进行了分析,还有大量车辆未能识别出号牌,包括经过的车辆没有抓拍成功,综合这些因素,总体号牌抓拍识别率不足70%。

我们也拿过车辆号牌的抓拍数据,和重点车辆GPS的数据做了碰撞分析,发现两边数据能够重合的只有50%-60%。

也就是说,尽管我们现在每天都有庞大的数据采集,但识别率并不高,进而导致了数据质量不高。

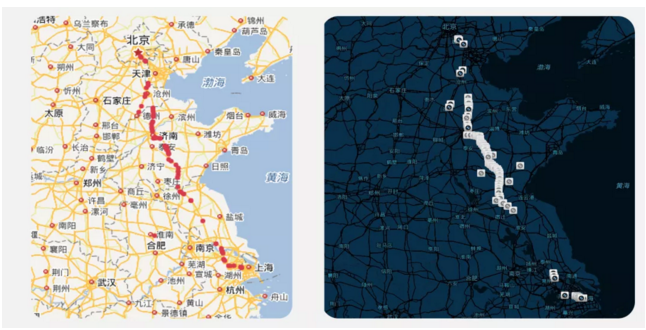

第二个方面,价值密度低的表现就是覆盖面不全。

《2020年加强重要点位交通监控设备联网接入和运维管理工作方案》要求年底前国家高速公路服务区、收费站卡口联网率达到60%以上,我们现在一直在追求全国的卡口都要联网到集成指挥平台中,但目前的现状是还有大量的卡口没有接入。

比如下图中展示的卡口,并不是每一个路段都有覆盖。

当我们分析高速公路的流量什么时候最大、什么时候最低、哪些路段流量最大的时候,若是中间有空缺,不管怎么分析,都不会得到确切的分析结果。

截至9月底,我们统计了高速公路服务区的卡口联网率是43.0%、收费站联网率只有21.0%,造成这种现状的因素有很多,其中一个因素就是因为有些设备并不是交管部门建的,而是其他部门建的,由于网络等各种因素的限制,这些卡口没有被接进来,还有一些服务区根本就没有安装卡口,这样的话就无法做到全覆盖。

如果做不到全覆盖,依靠数据进行的辅助决策就会有误导,甚至会带来不利的影响。

价值密度低的原因

为什么会出现价值密度低的情况,我们也简单的做了一些分析。

从技术层面来说,在集成指挥平台备案的卡口中,有5.1万套是3年前备案的,前端设备建设后基本不再升级,早期的设备和自身的技术没有那么先进,成像条件也不如现在,这样就造成了很多错误识别的情况。

比如下面的第一张图,车身上喷涂的联系电话比车牌本身还要清晰,而且它正好是5个数字,就容易被识别成号牌;第二张图中的农用车,因为很多卡口只能识别小型汽车和大型汽车,所以比较少见的农用车容易被误识别成机动车;第三张图中的新能源号牌,很多卡口都是在新能源号牌推出之前建设的,并不具备识别新能源号牌的能力;第四张图中的摩托车,包括电动车自行车等非机动车也无法识别。

从管理角度来说,很多卡口的位置标注都是由人工来完成,工作量大导致了标注的过程也很仓促,比如有些设备没有标注路上,当通过卡口位置计算两个卡口的距离,进而推算出车辆通行的速度等结果,然后使用这样的数据做大数据分析、建立模型,很可能造成结果和实际情况完全相反,得不到有价值的信息。

另外一个管理因素是对前端设备的运维也没有做到位,比如受到树叶遮挡、物体遮挡、号牌反光、补光不足、角度偏移、跟车过近等因素导致无法拍到号牌,这些都会造成在实际道路上通行车辆的信息没有被准确及时的采集到集成指挥平台中。

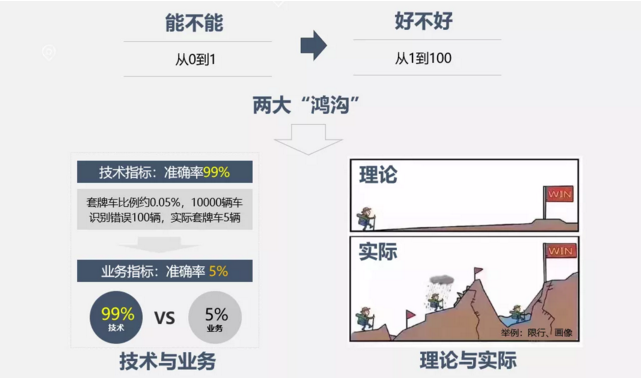

通过前面的分析,我们可以看出目前公安交管大数据(主要是机动车通行轨迹的大数据),数据质量并不高,由此也带来了一些影响,比如说我们现在的技术走在了前面,可以通过模型产生一些效果,相当于从技术上解决了“能不能”的问题,但是做完以后“好不好用”,还需要经过长期的特定场景下的应用来不断优化迭代。

“能不能”实际上只解决了从0到1的问题,也就是可以通过技术手段来实现,但是“好不好用”要解决从1到100的问题。

这里面有两大鸿沟,第一个是技术与业务的鸿沟,技术需要为业务提供服务,虽然技术发展到了一定程度,相应的技术指标可以达到很高,但应用到实际业务场景中中可能准确率(业务指标)很低,这中间还有很大的一个跨度需要解决;第二个是理论与实际的鸿沟,理论上的模型很完美,但投入到实际应用时又会发现各种各样的问题,达不到使用要求。

总结来说,大数据处理技术已经相当成熟,交管大数据应用还远远没有跟上。

目前技术研究的发展和推进主要由企业和高校来主导,技术本身没有问题,但技术在应用的过程中,大多使用的是实验环境下用以训练的数据,量比较小,且很多都是模拟的数据。

当然,有些地方为避免模拟数据带来的问题,也会挑选一些城市建立数据模型,但也仅仅是部分城市,不能代表全国,所以在理想的实验室数据环境下,模型很成熟,没有任何问题,但投入应用之后,会发现各地方的实际情况和预期并不相同。

前段时间,我们到各地去调研,发现很多地方都建了各种各样的大数据的应用,也确实收集了很多的数据,数据模型也有,但这些模型的应用很少,可能大数据平台建完以后,发几期宣传稿就结束了,只在上线的时候用了一两天,没有常态化的应用,其主要原因还是因为上述的两个鸿沟。

低价值密度下大数据应用常用方法

面对低价值密度的现状,有哪些常用的方法能解决当下应用的难题尤为重要。

我们先回顾一下标准的大数据处理流程。

首先是采集数据,采集完以后进行数据清洗,清洗完以后再对数据做分析和挖掘,最后在数据分析挖掘的结果基础上做一些可视化应用。

根据我们长时间的积累和观察,我们发现数据清洗的操作由始至终一直存在,数据采集、数据分析挖掘和具体应用的过程中,都需要清洗数据。

数据清晰和处理的方法如下所示:

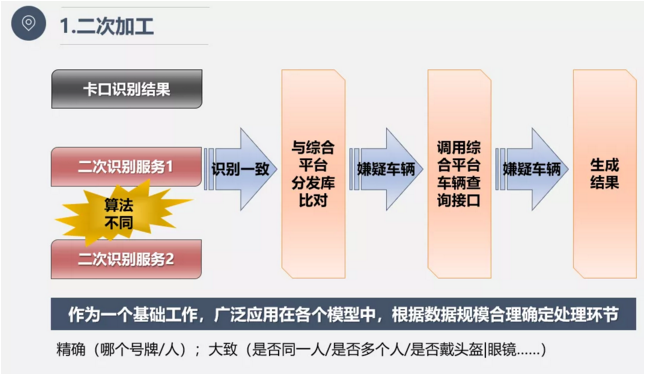

第一种方法是二次加工;

卡口识别结果准确率不高,就将卡口抓拍的图像做二次识别,将识别的结果再和卡口的数据做比较,如果两个是一致的,这个卡口的数据就可以用,如果不一致就扔掉;如果还不够,就再进行二次识别进行交叉验证,进而用可信度更高的数据在后面做应用。

当然,二次加工的方法不是单独的应用,它会跟其他的数据加工的方法结合在一起,另外,二次加工也不是每个环节都适合,尤其是二次识别,它需要对提取的图片的特征,所以消耗的时间比较大,一般这个过程不放在第一环节,而是经过初步的加工筛选以后,得到一个数据量比较小的数据集,之后再采取二次加工的方式。

二次识别除了对精确号牌的识别以外,还可以对车内的驾驶人,包括驾驶人的特征,做二次识别的处理,比如我们很多模型里面会涉及到只要判断这个人是不是同一个人,或者是只要看到里面有几个人,或者只要看到这个人有没有戴头盔、有没有戴眼镜这样的特征就够了。当然,有些场景需要通过二次加工以后,知道这辆车里面坐的是谁,他的身份证号码是多少,它的驾驶证是多少。

举个简单的例子,比如说要判断一个车有没有更换驾驶员,有些大车上有两个人,一个人具备大车的驾驶资格,另外一个人不具备驾驶资格,通过大数据分析嫌疑的车辆以后,只要把主驾驶和副驾驶两个人的特征提取出来,再交叉验证,看两人的座位有没有换,判断主驾驶人是不是同一个人,副驾驶人是不是同一个人,就能判断出该车辆是否涉嫌违法,并不需要知道他是谁,甚至都不需要提取他的个人信息,只需要提取他大致的特征,在短时间内,他们两个人如果穿的衣服不一样,就能很快的得到判断结果。

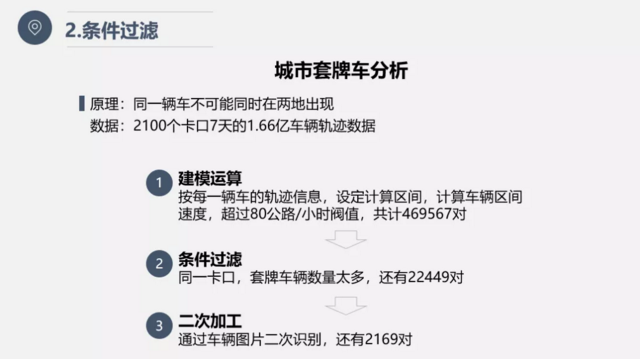

第二种方法是条件过滤;

这也是在大数据处理种最常用的方法,举个例子,城市套牌车的分析原理就很简单,同一辆车不可能同时在两地出现,一旦出现必定属于套牌的嫌疑车辆。

很早以前我们就提出来了这个原理,但是由于当时数据的处理能力还不够,所以这个思路很难实现,但是现在有了大数据技术以后,很容易就能实现。

但是我们在应用过程中也发现了很多问题,比如原始数据有2100个卡口,汇聚了7天的数据,总量达到1.66亿,如果仅仅按照算法模型来运算,我们得出的结果往往与实际情况严重不符,比如由于卡口位置问题、号牌识别问题、时钟校时问题等都会对分析结果造成严重干扰,通过条件过滤、二次加工后,对一些存在干扰的脏数据进行清洗,最终筛选出了2000多辆的套牌车。

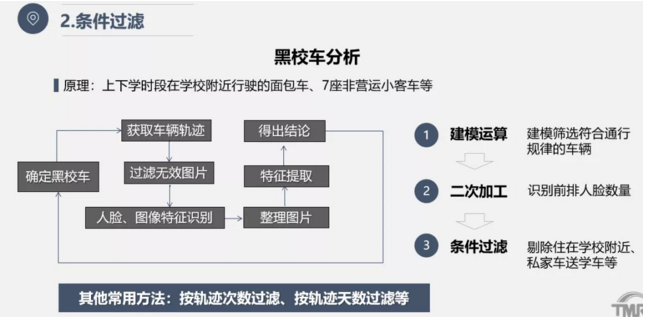

黑校车的分析原理也很简单,上下学时段在学校附近行驶的面包车、7座非营运小客车等车辆,但这些车辆平时并不出现,放假期间也不出现,通过大数据运算,确实能够筛选出符合特征的车辆,但实际应用过程中我们也发现存在一些给学校运送货物车辆、住在附近的送学车辆等造成一定干扰,因此通过一定的数据场景积累后按照条件过滤的方法剔除干扰数据后,才能得到我们想要的分析结果。

当然,还有一些其他的条件过滤的方法,比如像按轨迹次数过滤、按轨迹天数过滤等。比如在车辆通行特征规律画像、疫情防控大数据分析等过程中都用到了条件过滤的方法。

第三种方法是多元数据融合;

单纯用一种数据来分析结果,没有办法确定,也没有办法过滤时,可以再通过侧面的另外一种数据和现有的数据做交叉融合,以此来确定结果的准确性。

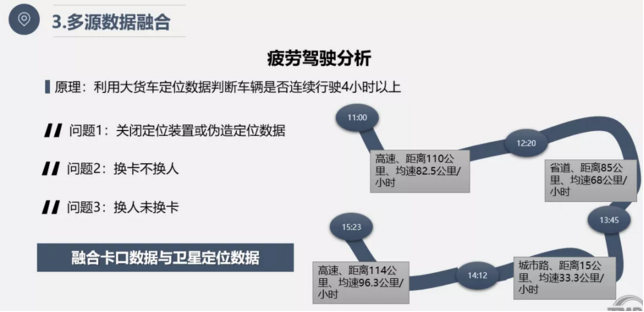

比如疲劳驾驶的分析原理就是利用大货车定位数据判断车辆是否连续行驶4小时以上,就可以认定该车存在疲劳驾驶的嫌疑。

然后,把定位数据和卡口数据做交叉融合,卡口是能够拍到货车前部图片,哪个位置、哪个驾驶员驾驶都能一清二楚,把图片作为证据给驾驶员看,基本上驾驶员不会抵赖,同时,计算两个卡口之间车辆的通行时间和通行速度,进而拿卡口数据和 GPS定位数据做交叉验证,一方面能认定是否存在没有停车的嫌疑,同时也读到车辆的GPS数据,还能知道车辆驾驶员是否有更换,通过这些数据的融合,能提高数据的准确性,若是单一数据,分析结果很多时候都不能用。

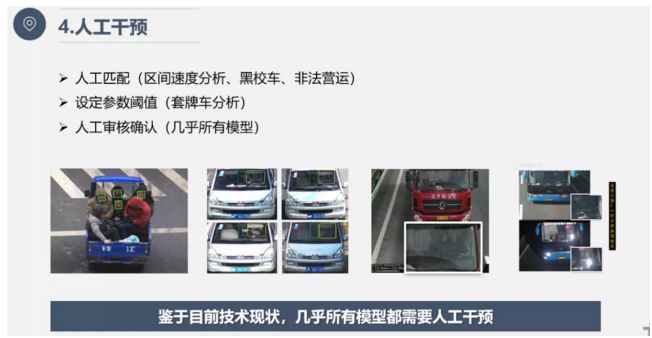

第四种方法是人工干预;

目前的大数据分析还没有达到非常准确、非常智能的程度,完全通过算法来推断出准确的结果并不现实,所以很多时候需要人工干预。

人工干预也分很多场景,有些是在事前人工干预,有些是在事后,还有些是组合式的,事前事后都需要人工干预。

比如分析区间通行车辆的速度,首先得知道哪一个是区间的起点,哪一个是区间的终点,这都需要提前人工标注好哪个是起点哪个是终点,另外,还有设定参数的阈值,比如像套牌车的分析、区间测速的分析等等,可以设定速度,因为有些卡口的时间不一定准确,所以算出来的速度会有偏差。

当然,还有一个最常用的就是人工审核,得到最终的分析结果数据集后,还是需要人工审核判断,因为交管很多应用都涉及到交通违法的处罚,一定要保证数据的准确性,所以基本上每一个模型的最后都会有一道人工审核确认的环节。

小结

最后,简单做一个总结。

在数据应用方面,还是要深化数据治理工作,数据的清洗、模型的优化迭代都属于数据治理的工作范畴,另外也需要接入更多的数据,比如保险的数据、事故的数据等等,和目前的卡口数据做多维的交叉验证,更好的发挥大数据的作用。

在数据采集方面,也要加强源头的管理,保证第一手采集到的数据就是准确及时无误的。因此,基于目前的现状,我们需要组织全国的前端设备升级和运维保障工作。下一步我们打算继续组织视频专网集成指挥平台建设,加强前端卡口设备的运维的管理,通过AI智能运维自动检测卡口设备的采集角度是否准确,数据传输是否及时等。

希望通过大家共同的努力,把公安交管的大数据应用得更好。

未经许可,任何人不得复制、转载、或以其他方式使用本网站的内容。如发现本站文章存在版权问题,烦请提供版权疑问、身份证明、版权证明等材料,与我们联系,我们将及时沟通与处理。